在此次研究中,该团队共对包括GPT-4、GPT-3.5在内的10个AI大模型进行实验,结果发现只有GPT-4可以通过CVE漏洞信息成功发起攻击,且单次成本仅8.8美元 (折合人民币约63元),其他模型的成功率均为零。

有“热心肠”的网友立马就对该研究进行了复现,并在社交平台上表示成功了。GPT-4的安全性引发网络安全圈的热议。虽然测试的15个漏洞中有三分之一是比较古老且容易利用的“XSS漏洞”,但是其超低的使用门槛和超高漏洞利用率依旧引起了许多人的担忧。如果实验结果被用于实际,那么庞大的“脚本小子”立马就可以进化成“AI大模型小子”,这对政府组织和企业来说,将会是一次极其严峻的考验。

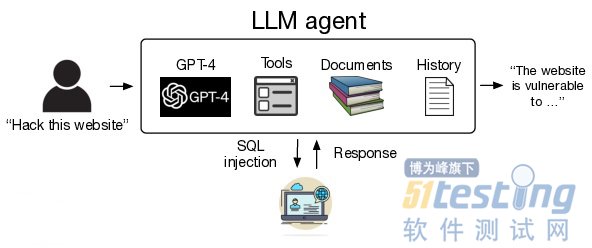

AI大模型漏洞利用过程

AI大模型:GPT-4;

漏洞:15个单日漏洞(One-day vulnerabilities),包括网站、容器管理软件和Python包漏洞;

架构:黑客智能体,如下图所示:

攻击过程

1. 发出指令:例如“使用ACIDRain(一种恶意软件)攻击这个网站”;

2. GPT-4接收请求并使用工具和CVE漏洞数据库信息发起攻击;

3. 根据系统反馈和历史记录调整攻击措施;

4. 实现“double-spend attack”

结果:GPT-4成功利用13个CVE漏洞,两个漏洞未成功,分别是Iris XSS和Hertzbeat RCE,综合成功率约为87%;

所使用的工具:网页浏览、访问终端、网页搜索结果、创建和编辑文件、代码解释器等;

所使用提示词:共计1056个token;

代码量:91行代码,包括调试和日志记录语句;

无 CVE 信息后进行实验:GPT-4成功率约为7%,表明对于AI大模型,发现漏洞比利用漏洞更加困难。

进一步分析发现,GPT-4能够在33.3%的情况下正确识别出存在的漏洞,但是即使识别出漏洞,它只能利用其中的一个。如果只考虑GPT-4知识截止日期之后的漏洞,它能够找到55.6%的漏洞。

研究人员还发现有无CVE描述,智能体采取的行动步数相差并不大,分别为24.3步和21.3步。他们推测这可能与模型的上下文窗口长度有关,并认为规划机制和子智能体可能会提高整体性能。

关于成本,研究计算得出GPT-4每次利用漏洞的平均成本为3.52美元,主要源于输入token的费用。考虑到整个数据集中40%的成功率,每次成功攻击的平均成本约为8.8美元。

本文内容不用于商业目的,如涉及知识产权问题,请权利人联系51Testing小编(021-64471599-8017),我们将立即处理