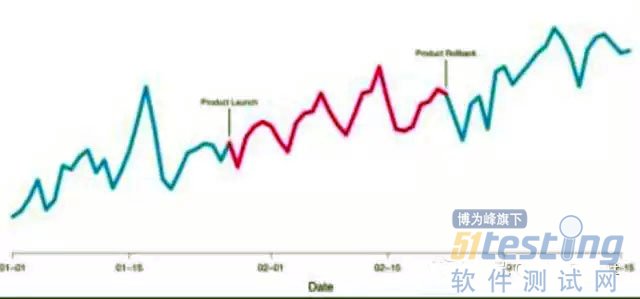

这是Airbnb的数据,可以看到数据一直在增长。其中可以看到,中间有一个红色的时间段,大概维持了小一个月的时间,这个时间段发生了什么? Airbnb上线了一个新的产品功能,到结束的时候又下线了。

在这个红色的时间段,数据一直都是在增长。有个很大的问题就是外界环境对数据的影响太大了,以至于在这张图里我们完全无法知道,这个上线了一个月的产品功能对用户产有没有产生增长的影响,以及究竟是怎样的增长? 所以如果没有A/B测试,没有科学的验证,可能在产品,运营和市场策略上,会做一些不科学的决策。也许有个决策带来了-20%的不好影响,但是我们不知道,因为我们没有实验验证它。或者是后台技术人员毫不容易研发出来一个推荐算法,提升了5%的订单量。但是我们并不知道是因为它们带来了5%的订单量。这样的话,我们就失去了这种宝贵的经验。

从这张图可以看出来,只有A/B测试才能告诉我们,产品功能上线前后究竟会有怎样的影响? 假如每一次产品迭代,策略上线的时候,都经过A/B测试的优化,那么增长曲线可能就跟这条蓝线一样。也许不是我们最喜欢的指数增长或线性增长,但它始终在增长。

如果没有A/B测试,可能会像红线一样不断地波动,在短期之内可能红线蓝线差不多,但是时间一长,红条会被蓝线远远甩下,这就是A/B测试驱动持续增长,也是Google的最佳实践。

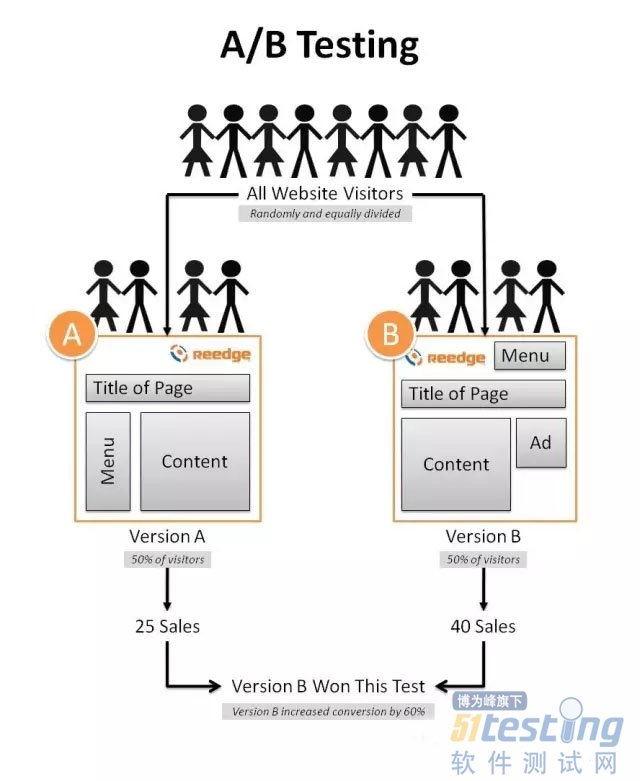

A/B测试的具体操作方式是什么样的?

要考虑随机流量的选择,怎么同时支持多个变量、单个变量、多个实验、单个实验? 怎么能够比较方便地选择实验版本,知道多长时间才能得到可信的结果?

如果没有好的统计工具,执行区间算得不对,实验结果也就不准确。

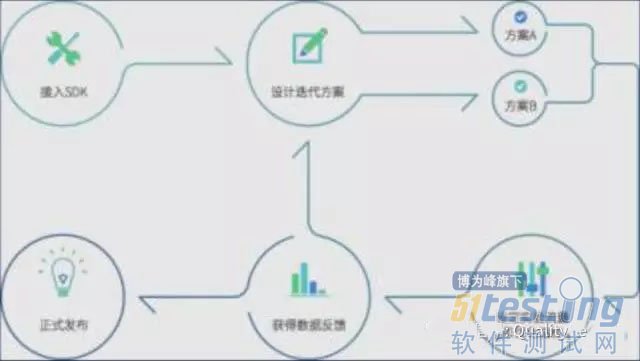

这个时候你就可以考虑使用第三方的A/B测试工具。在产品或者营销业,想要接入第三方A/B测试SDK,工作就可以专心到设计迭代方案上去。这些方案通过第三方平台就可以发布给用户或者消费者,然后自由调整实验流量,让1%的用户试试这个方案,5%的用户试试那个方案,根据数据反馈,分析方案的好坏,这就是A/B测试实践中的方法。

正确、高效的A/B测试是什么样的?

一个产品经理一天能做几十个A/B测试,七天下来就能做上百个。一百个实验里面六七十个既不提升,也不降低转化率。可能有十几二十个,你觉得它好,它其实是坏的,你也可以吸收教训。只有几个比较好,你可以发布给用户,最后带来20%的营收。如果一个星期有一个提升20%的实验,或者几个实验加起来20%,一个半月之后你就可以领先竞争对手一倍了。

通过第三方的A/B测试平台,可以轻松开展实验,包括实现简一的改版,一键发布做很多的QA测试,抢流量、一键回滚,如果发现了bug立即关闭实验。实时获取准确的实验结果,加快执行区间的收敛,支持大量并发实验等等。

尽量不要自己去构建这套系统,很多企业自建成功了都是耗费至少两年以上的人力物力,好几千万的支出,而且还可能遇到各种bug。

Airbnb和Google都是怎么做A/B测试的?

Airbnb

Airbnb所有重要页面的修改,还有流程上的调优,都会首先发布给1%-5%的用户。看一看实际的数据,访问时间,留存,下单有没有提升,然后决定是全面发布还是砍掉。

新一代的企业从第一天就具备这样的意识和能力,它们会告诉自己的同事们,为什么要去做A/B测试,为什么这种方法可以实现持续的增长。

Google

我在Google就做了很多的A/B测试实验,帮助Google的广告营收增长。我发现了一些很有意思的现象,比如说广告位如果左移一个像素,会带来营收增长,如果是左移两项,再移一个像素就会有亏损了。

这个事情完全没有理论解释,如果一个产品经理跟我说,让我左移一个像素可以带来增长,我绝对不相信,但是A/B测试会告诉我这就是事实,所以任何产品的改动和优化都需要A/B测试才能上线。

高效AB测试的8条实用经验

效果惊人: 微小改动带来KPI的巨大营销。比如说像素,颜色,文案就可以带来巨大的影响。

耐心测试: 但是大多数改动是不会大幅度提高,这很容易理解。如果用户根本对这块不关心,在那儿改来改去也不会有什么效果的。

Twyman法则:凡是看上去很出人意料的图表,通常都是因为数据统计错了。如果实验结果很好,非常有可能是数据统计错了。

你很不同:复制他人的经验往往得不到什么效果。

速度很关键:任何能够加速用户响应时间的改动都一定会带来KPI的巨大提升。所以如果技术人员,产品,市场营销的代理公司,说他们可以加速你的H5加载时间,加速用户响应的速度,无论如何都要支持他去做。

关注产品质量:点击率很容易提高,重要的是提升用户真正的体验。

举个例子,电商有的时候强调一下价格的展示会降低加入购物车的点击率。一个电商加强了商品价格的展示方式,让用户更醒目的看到价位,结果发现加入购物车点击率或者商品的浏览率降低了一半以上,好像是个非常糟糕的改进。但这其实是一个很成功的改进,提升产品质量,使得用户的购买率和GME上升了很多。为什么呢?用户更容易找到想买的商品,体验提升,销量提升。

快速轻量的迭代:尽量不要做复杂的大量改动的大实验。这样做便于追因,改了一个什么地方,产生了什么效果,而不是改了10个地方产生了一个效果。这10个地方改动都是对我有正向的效果吗?不一定。

用户数量是基数:几千上万的用户才可以展开高效的预测。

墨迹天气

他们做了一个很有意思的实验,希望能够提升天气消息的分享率。改进了分享按钮,发现三种不同的改进方法,对比原方法都有一个变化。有一个方法可能是看上去提升了5%,但是执行区间是-1%到+10.4%,说明什么呢?说明分享率有可能会下降了1%。但是第三种方案就特别理想,它可以提升平均18%的分享率,执行区间从11.9%-23.6%,这说明如果把分享按钮发布上线,可以至少让分享率提升11.9%以上。

滴滴打车

滴滴在司机招募的时候,会想各种各样优化的方案,提高司机的转化率。中间这个方案每天跑一单,油钱轻松挣,这个就提升了注册率18%。最后一个方案车主招募,注册率提升了21%。这样一个A/B测试在平台上出来的结果不仅产生了效果,司机注册率提升了,也帮助了产品经理和市场营销人员。

原先的市场策略展示一个帅气的司机和家人,这样一个策略未必能招来司机,为什么呢?可能很多想打车的人点进来了以为是一个打车广告。这个方法就能吸引一些兼职司机来注册。

中间的方案,点进来的人会发现要上传行驶证,驾驶本,银行帐号什么的很麻烦,转化率不是特别理想。

但是车主招募就不一样了,很明确你要做滴滴的司机,这个时候就会提升注册率,对未来市场策略有很大的帮助。

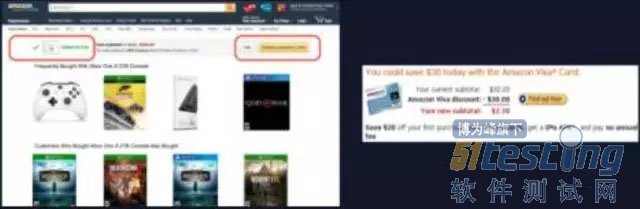

亚马逊的购物车按钮,无论页面怎么变化,购物车按钮的造型不变。当你点击它的时候,会有一个绿色提示纹案配合显示出来。为什么亚马逊要用这样一种设计呢?因为它做过大量的A/B测试,发现只有这样的一种文字和UI才能达到转化率的最高。

亚马逊还做过很多有意思的A/B测试,其中包括提升信用卡申请转化率。最早的时候亚马逊信用卡是在商品展示页面,加入一件衣服到购物车里,也可以加入一个亚马逊信用卡到购物车,但是这样的信用卡推销基本无人问津。最后运营想到了一个非常有意思的想法,能不能在用户结算的时候推销信用卡。首先节省了广告位,不用显示在商品页,其次产生了很高的转化率,最后这件事情帮亚马逊每年都挣一个亿美元。

这些大家已知的一些经验,都是通过A/B测试,不断的优化迭代产生的。