对于我们日常的数据清理、预处理和分析方面的大多数任务,Pandas已经绰绰有余。但是当数据量变得非常大时,它的性能开始下降。

我们以前的两篇文章来测试Pandas 1.5.3、polar和Pandas 2.0.0之间的性能了,Polars 正好可以解决

大数据量是处理的问题,所以本文将介绍如何将日常的数据ETL和查询过滤的Pandas转换成polars。

Polars的优势

Polars是一个用于Rust和

Python的DataFrame库。

·Polars利用机器上所有可用的内核,而pandas使用单个CPU内核来执行操作。

· Polars比pandas相对轻量级,没有依赖关系,这使得导入Polars的速度更快。导入Polars只需要70毫秒,而导入pandas需要520毫秒。

· Polars进行查询优化减少了不必要的内存分配。它还能够以流方式部分或全部地处理查询。

· Polars可以处理比机器可用RAM更大的数据集。

ETL

Extract, Transform, and Load (ETL)的过程是怎样的:

“提取、转换和加载(ETL)是将来自多个数据源的数据组合到称为数据仓库的过程。ETL使用一组业务规则来清理和组织原始数据,并为存储、数据分析和机器学习(ML)做好准备。可以通过数据分析解决特定的业务智能需求(例如预测业务决策的结果、生成报告、减少操作效率低下,等等)。

Polars和Pandas都支持从各种来源读取数据,包括CSV、Parquet和JSON。

df = pl.read_csv('data.csv')

df = pl.read_parquet('data.parquet')

df = pl.read_json('data.json')

对于数据的读取方面和Pandas基本一致。

转换是ETL中最重要、最困难和最耗时的步骤。

polar支持Pandas函数的一个子集,所以我们可以使用熟悉的Pandas函数来执行数据转换。

df = df.select(['A', 'C'])

df = df.rename({‘A’: ‘ID’, ‘C’: ‘Total’})

df = df.filter(pl.col('A') > 2)

df = df.groupby('A').agg({'C': 'sum'})

这些Pandas函数都可以直接使用。

创建新列:

df = df.with_column(pl.col(‘Total’) / 2, ‘Half Total’)

处理空值:

df = df.fill_null(0)

df_filled = df.fill_null('backward')

df = df.fillna(method='ffill')

Dataframe 的合并

#pandas

df_join = pd.merge(df1, df2, on='A')

#polars

df_join = df1.join(df2, on='A')

连接两个DF

#pandas

df_union = pd.concat([df1, df2], ignore_index=True)

#polars

df_union = pl.vstack([df1, df2])

polar使用与Pandas相同的函数来将数据保存到CSV、JSON和Parquet文件中。

# CSV

df.to_csv(file)

# JSON

df.to_json(file)

# Parquet

df.to_parquet(file)

最后,如果你还需要使用Pandas做一些特殊的操作,可以使用:

这可以将polar的DF转换成pandas的DF。

最后我们整理一个简单的表格:

数据的查询过滤

我们的日常工作中,数据的查询是最重要,也是用的最多的,所以在这里我们再整理下查询过滤的操作。

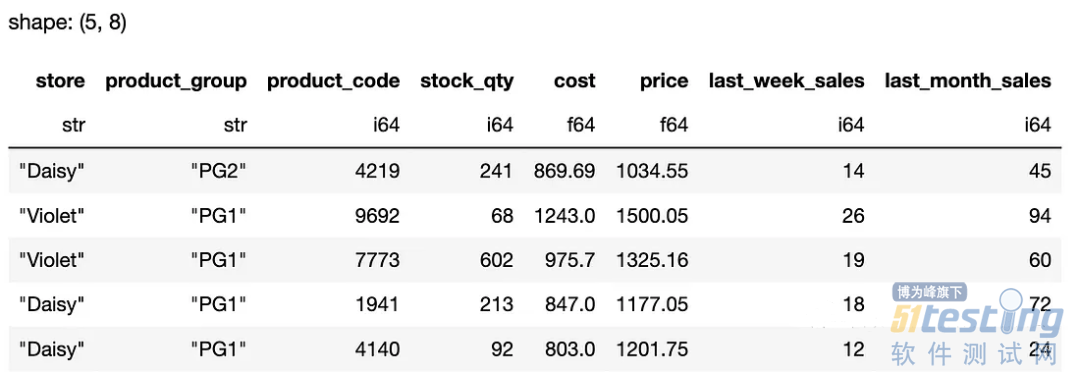

首先创建一个要处理的DataFrame。

# pandas

import pandas as pd

# read csv

df_pd = pd.read_csv("datasets/sales_data_with_stores.csv")

# display the first 5 rows

df_pd.head()

# polars

import polars as pl

# read_csv

df_pl = pl.read_csv("datasets/sales_data_with_stores.csv")

# display the first 5 rows

df_pl.head()

polars首先显示了列的数据类型和输出的形状,这对我们来说非常好。下面我们进行一些查询,我们这里只显示一个输出,因为结果都是一样的:

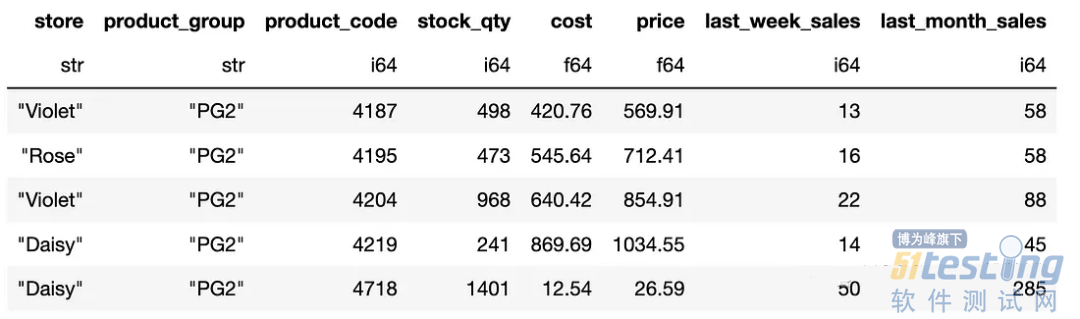

1、按数值筛选

# pandas

df_pd[df_pd["cost"] > 750]

df_pd.query('cost > 750')

# polars

df_pl.filter(pl.col("cost") > 750)

2、多个条件查询

pandas和polar都支持根据多个条件进行过滤。我们可以用“and”和“or”逻辑组合条件。

# pandas

df_pd[(df_pd["cost"] > 750) & (df_pd["store"] == "Violet")]

# polars

df_pl.filter((pl.col("cost") > 750) & (pl.col("store") == "Violet"))

3、isin

pandas的isin方法可用于将行值与值列表进行比较。当条件包含多个值时,它非常有用。这个方法的polar版本是" is_in "。

# pandas

df_pd[df_pd["product_group"].isin(["PG1", "PG2", "PG5"])]

# polars

df_pl.filter(pl.col("product_group").is_in(["PG1", "PG2", "PG5"]))

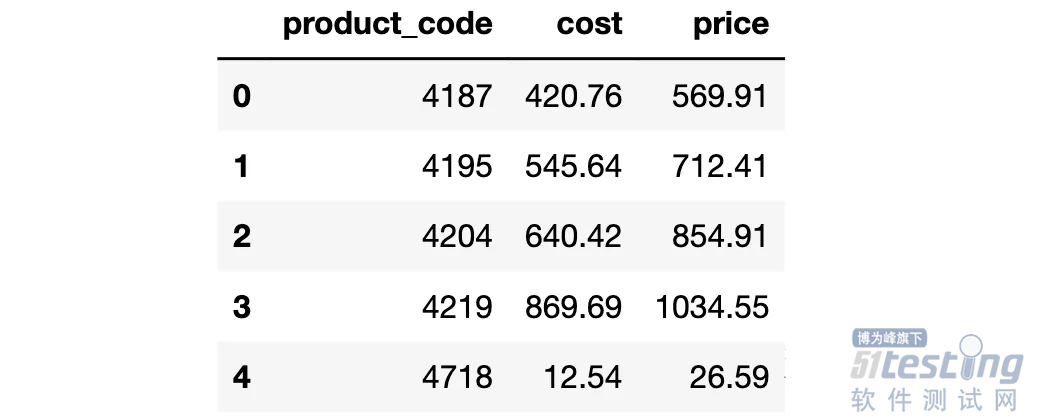

4、选择列的子集

为了选择列的子集,我们可以将列名传递给pandas和polar,如下所示:

cols = ["product_code", "cost", "price"]

# pandas (both of the following do the job)

df_pd[cols]

df_pd.loc[:, cols]

# polars

df_pl.select(pl.col(cols))

5、选择行子集

pandas中可以使用loc或iloc方法选择行。在polar则更简单。

# pandas

df_pd.iloc[10:20]

# polars

df_pl[10:20]

选择相同的行,但只选择前三列:

# pandas

df_pd.iloc[10:20, :3]

# polars

df_pl[10:20, :3]

如果要按名称选择列:

# pandas

df_pd.loc[10:20, ["store", "product_group", "price"]]

# polars

df_pl[10:20, ["store", "product_group", "price"]]

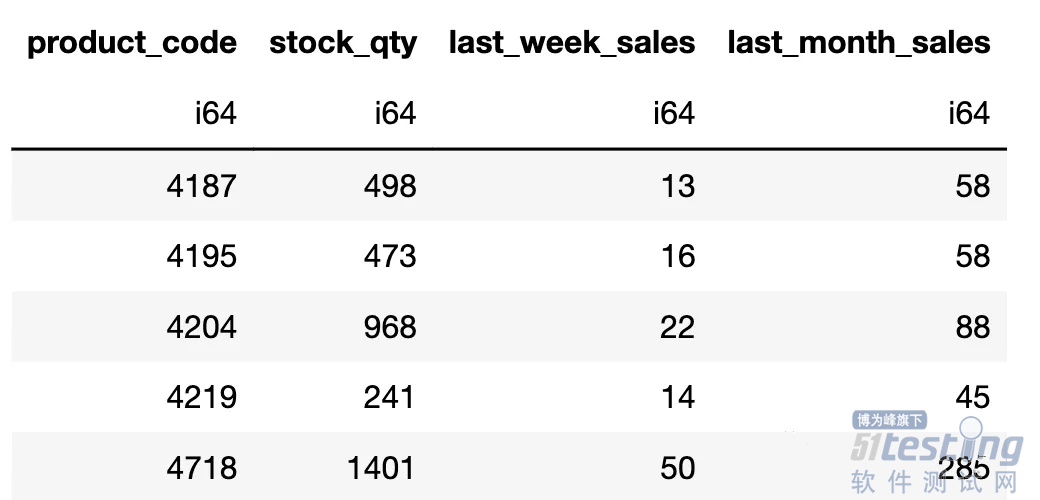

按数据类型选择列:

我们还可以选择具有特定数据类型的列。

# pandas

df_pd.select_dtypes(include="int64")

# polars

df_pl.select(pl.col(pl.Int64))

总结

可以看到polar与pandas非常相似,所以如果在处理大数据集的时候,我们可以尝试使用polar,因为它在处理大型数据集时的效率要比pandas高。