11 还有什么领域也用AB测试?

对照实验,也叫随机实验和A /B测试,曾在多个领域产生深远的影响,其中包括医药,农业,制造业和广告。通过随机化和适当的实验设计,实验构建了科学的因果关系,这就是为什么对照实验(A/B测试)是药物测试的最高标准。

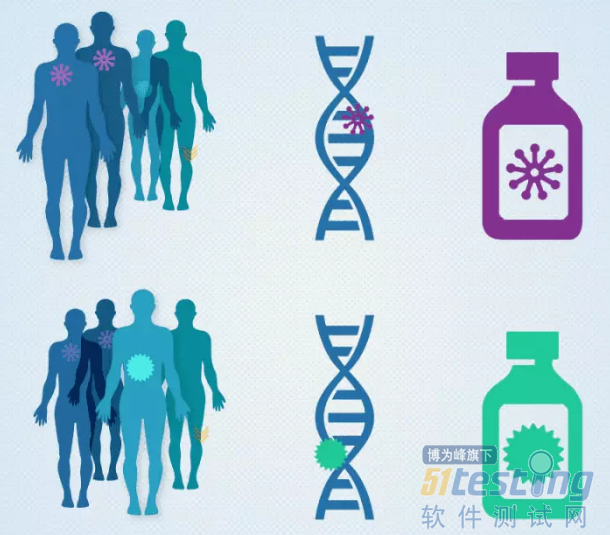

正是考虑到后验方法的局限性,西医(现代医学科学)首先引入了 A/B 测试的方法来验证新药的疗效。新药的验证可能是这样一个流程:100 位患者,被测试医生悄悄划分为 AB 两组,注意患者自己并不知道自己被分组,注意 AB 两组患者的健康情况应该是接近一致的;A 组患者将会得到试验新药,B 组患者将会得到长的和新药几乎一模一样的安慰剂;如果最终 A 组患者比 B 组的疗效更好,才能证明新药的药效。

12 A/B测试的价值是什么?

AB测试的实验能力可以用更科学方法来评估规划过程中不同阶段的想法价值。

A/B测试其实是一种“先验”的实验体系,属于预测型结论,与“后验”的归纳性结论差别巨大。A/B测试的目的在于通过科学的实验设计、采样样本代表性、流量分割与小流量测试等方式来获得具有代表性的实验结论,并确信该结论在推广到全部流量可信。

通过值得信赖的实验来加速创新。通过解决技术和文化的挑战,我们给软件开发人员、项目经理和设计师一副“公正的耳朵”,帮助他们听取客户真实的诉求以及用数据驱动的决策。

13 A/B测试的应用场景有哪些?

A/B测试这种方法论的应用非常广泛,包括在Web产品、移动产品、数字广告优化领域的应用。应用场景由小到大可以可以分为:

元素/控件层面

功能层面

产品层面

公司层面

14 A/B测试中需要用到的基本概念有哪些?

样本空间、样本特征、实验流量

假定这是个电商的APP,产品有100万用户

样本空间:100万用户样本特征:这100万用户有各式各样的特点(性别、地域、手机品牌与型号、甚至是不是爱点按钮等行为。。)

实验流量:100万用户成为100%的流量;假定将这100万用户根据样本特征与相似性规则分为100组,那每组就是1万人,这1万人就是1%的流量

采样、代表性误差、聚类

相似性采样:在A/B测试的实验中,需要保证小流量的实验具备代表性,也就是说1%的流量做出来的实验结果,可以推广到100%的用户,为了保证这一点,需要保证1%的流量的样本特征与100%流量的样本特征具备相似性。(说个最简单的逻辑:假定把所有小米手机用户均匀的分到这100组中,那第一组的所有小米手机用户的特征与第2组-第100组的所有小米手机用户具备相似性)

代表性误差:代表性误差,又称抽样误差。主要是指在用样本数据向总体进行推断时所产生的随机误差。从理论上讲,这种误差是不可避免的,但是它是可以计算并且加以控制的。(继续小米。。尽管把小米用户均匀的分成了100组,但是不能完全保证每个组里的小米用户的数量、性别、地域等特征完全一样,这就带来了实验误差风险)

聚类:物理或抽象对象的集合分成由类似的对象组成的多个类的过程被称为聚类,也就是在分配小米用户的过程中,需要按照实验目的的不同把特征相似性高的用户认为是一类用户,比如定义100次点击为高频点击,可能在某些情况下也会认为99次点击的用户跟100次点击的用户是一类用户置信度与置信区间在统计学中,一个概率样本的置信区间(Confidence interval)是对这个样本的某个总体参数的区间估计。置信区间展现的是这个参数的真实值有一定概率落在测量结果的周围的程度。置信区间给出的是被测量参数的测量值的可信程度,即前面所要求的“一定概率”。这个概率被称为置信水平。

置信度:简单来将表示可信程度,一般来说95%的置信度就很好了,一些及其严苛的A/B测试实验才会到99%的置信度。差别在于,越高的置信度得出结论的实验时间越长、流量要求越高

置信区间:从前面的概念中也讲了,1%的流量尽管具备了代表性,但是跟100%的流量还是有差异的嘛,所以实验结果的评判要有一定的前提的,置信度就是这个前提,置信区间表示在这个置信度的前提下,实验结果很可能会落在一个区间内,比如下图,95%的置信度的前提下,置信区间为[-2.3%, +17.4%],可以解读为这个A/B测试的实验既有可能使“点击次数”降低2.3%,又有可能提升17.4%。说明这个实验结果还不稳定,可能是试验时间短或者是流量不够。

15 数据化驱动决策与确定性提升是什么意思?

数据化驱动决策:A/B测试是典型的靠谱数据化驱动决策,先用A/B测试的方式,让比如1%或者5%的用户进行实验,让用户用实际的行为来告诉你哪个好。比如这1%或者5%的用户通过“点击次数”这个指标告诉你,他们不喜欢橙色的设计。这就是数据化驱动决策,不用一屋子人你拍桌子我瞪眼的争辩到底那个设计好,让真实的用户跟数据告诉你到底哪个更好。确定性提升:这就更好解释了,有了这么个工具,每次只有效果好了才会上线,也就意味着每次优化都能比以前更好,大大提高用户的体验和产品经理的自信心。

16 Airbnb的产品是怎么样做AB测试的?

Airbnb经常用灰度发布 和 A/B测试对重要页面的修改和流程上的调优,通过灰度发布到1%或者5%的用户,看其实际对用户的数据影响(访问时间增加、留存提高、下单率提高等),决定此修改到底是100%发布还是被砍掉。

Airbnb 从第一天就开始做 A/B 测试,不仅在自己的体系里做,还用第三方工具做,保证所有的决策,从产品,到运营,乃至到战略,都是经过数据驱动的优化决策。每一个改动,都先用 1%的流量来试验,然后再推到 5%,再到 10%,到 20%,到 50%,最后再发布给所有用户。通过A/B测试,他们还有一个关于推介文案的结论:给用户展示“利他”的文案,比“利己”的更容易带来转化。如图所示,告诉用户“邀请好友可以获得25美元”的效果就不如“给你的好友赠送25美元的旅行经费”更打动人。

17 Google是怎么样做AB测试的?

Google每个月从上百个A/B测试中找到十几个有效方案,月营收提升2%左右,10亿美元的规模。很难解释的是广告位左移一个像素带来X%的增收,左移两个像素带来Y%的亏损。

在Google,任何产品改动需要A/B测试才能上线。

Google X 生命科学分部的负责人 Andy Conrad 在《财富》的一篇文章中曾提到:

对于一个问题 Larry 会尝试用 1、2 种办法去解决,并且在策略上会对两者都同时下注。

Google 几乎所有的产品目录似乎都要进行大型的 A/B 测试。正如 Google 的搜索引擎不断从 Web 上收集数据加以学习和改进一样,Google 公司本身也是这么运作的。它给单个问题提供了多个解决方案,希望能从中决出优胜者。

这种多产品策略对于 Google 的长期健康来说是好的,但它也浪费了许多资源。到处都是重复的工作,但 Google 的 Adsense 和 Adwords 带来了那么多的收入,至少现在 Google 挥霍得起。

Google 往往喜欢针对同一客户群推出多项竞争产品。这样的话,如果一个产品失败了,也许另一个产品能够补上。最极端的例子是 Google 的即时通信解决方案。Android 上一度曾出现过 4 款不同的产品:Google Talk、Google+ Messenger、Messaging (Android 的短信应用)以及 Google Voice。Google Hangouts 最终胜出,把其他的都合并进了一个平台。Google 平时就是这样折腾的。其行动表明,自己并不相信一个问题只有一种解决方案,哪怕这样会让用户的日子好过得多。因为它需要应对外部各个领域的竞争对手,而且 Google 似乎也认为没理由竞争就不能出自内部—让自己的产品自相残杀。

18 在线销售的定价策略能否用AB测试?

伴随着产品迭代、促销等等因素影响,什么时候降价是对自己最有利的策略,完全可以A/B测试来解决。

19 移动端基于A/B测试的灰度发布怎么做?

就目前移动端的产品来说,iOS的应用商店审核期是个大大大坑,任何BUG打补丁还得再来一遍,也就意味着补丁的审核期内用户带着BUG使用,这个太致命了,用户的获取成本高的吓人,因为这个流失太不值得了,基于A/B测试的灰度发布更重要的不是优化,而是保护性发布,先通过小流量的实际用户测试,有BUG或者新版本体验不好,可以立即回滚到老版本,简单有效。

20 为什么很多公司实施A/B测试效果并不好?

大多数的产品或功能上线前都会进行测试,实际上很多的测试行为并不科学,特别是很多定向的用户测试经常会有这个弊端,简单来说,如果新上线的一个功能,所有的研发工程师都说好,那是不是意味着所有的用户都觉得好?很多情况下是否定的。当然这个例子比较简单,实际上很多A/B测试方法并没有考虑到这个问题,以至于最后得出的结论跟实际情况差异巨大。

要解决这个问题,对采样、聚类、流量分割等要求非常的高,这也是为什么A/B测试工具不能像很多统计工具一样,埋个点看数据,再根据数据反推业务逻辑,而是要充分与业务结合,从一开始就应该考虑业务策略,让用户去选择适合其口味的产品。

通过AB测试来优化产品的方法在国外已经被广泛应用,现在这种代表先进生产力的方法如同GitHub、Docker、APM一样也正在逐渐被国内广大开发团队所接纳。如果自己公司里面缺乏专业能力和经营,可以尝试优化平台来提高产品的设计、研发、运营和营销的效率,降低产品决策风险,同时也能够帮助用户用数据优化移动广告,让流量的变现价值更大。

上文内容不用于商业目的,如涉及知识产权问题,请权利人联系博为峰小编(021-64471599-8017),我们将立即处理。