6.hdfs-site.xml配置

<configuration> <property> <name>dfs.namenode.secondary.http-address</name> <value>10.10.11.181:50090</value> </property> <property> <name>dfs.replication</name> <value>3</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>file:/root/hadoop/hdfs/namenode/dfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>file:/root/hadoop/hdfs/datanode/dfs/data</value> </property> <property> <name>dfs.webhdfs.enabled</name> <value>true</value> </property> </configuration> |

7.配置mapred-site.xml

先复制再修改

[root@master hadoop]# cp mapred-site.xml.template mapred-site.xml <configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> <property> <name>mapreduce.jobhistory.address</name> <value>192.168.188.111:10020</value> </property> <property> <name>mapreduce.jobhistory.webapp.address</name> <value>192.168.188.111:19888</value> </property> </configuration><span style="font-size:12px;"> </span> |

8.yarn-site.xml配置

<configuration> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name> <value>org.apache.hadoop.mapred.ShuffleHandler</value> </property> <property> <name>yarn.resourcemanager.address</name> <value>master:8032</value> </property> <property> <name>yarn.resourcemanager.scheduler.address</name> <value>master:8030</value> </property> <property> <name>yarn.resourcemanager.resource-tracker.address</name> <value>master:8031</value> </property> <property> <name>yarn.resourcemanager.admin.address</name> <value>master:8033</value> </property> <property> <name>yarn.resourcemanager.webapp.address</name> <value>master:8088</value> </property> </configuration> |

9.然后把在master的配置拷贝到slave1和slave2节点上

scp -r hadoop-2.7.3 root@192.168.188.112:/root/package

三、启动hadoop

1.格式化命令。因为已经配置了hadoop的环境变量,所以不一定非要在hadoop的安装目录输入格式化命令。

[root@master sbin]# hdfs namenode -format

2.启动

[root@master sbin]# start-all.sh

四、用jps查看结果

启动后分别在master和slave1和slave2下查看进程。

master如下:

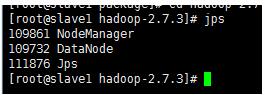

slave1如下:

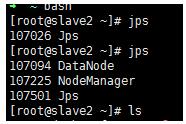

slave2如下:

则表示成功。

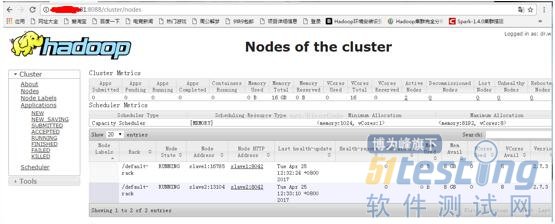

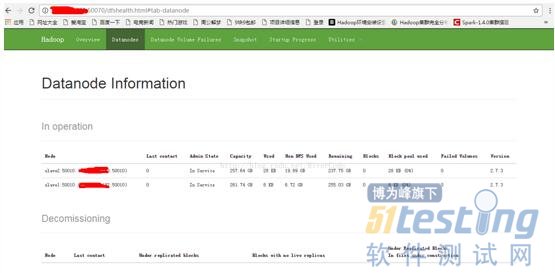

五、界面查看验证

输入http://192.168.188.111:8088/

输入http://192.168.188.111:50070/

到此,hadoop-2.7.3完全分布式集群搭建成功。